CLO 1.1 Chat LLM Optimization

כמה דברים שיכולים לשפר את איכות הצ’אט ולהוריד עלויות 🙂

ארגונים רבים החלו לממש פתרונות מבוססי LLM כדי להנגיש את המידע הארגוני ללקוחות חיצוניים ולעובדי הארגון.

מדובר בפרויקטים חשובים עם פוטנציאל לערך עסקי רב.

כשמתקדמים בפרויקט ונערכים לפרסום (עלייה לייצור) באים לידי ביטוי כמה אתגרים מרכזיים

1. כיצד לוודא שהתשובה שאנחנו מספקים מדוייקת ואינה מטעה? (Scoring)

2. איך מבצעים אופטימיזציה לעלות השירות / ניצול המשאבים? (במימוש לא נכון LLM יכול להיות מאד יקר)

3. איך מתחזקים, משפרים את התשובות ומרחיבים את תחומי הכיסוי של מערכות מסוג זה?

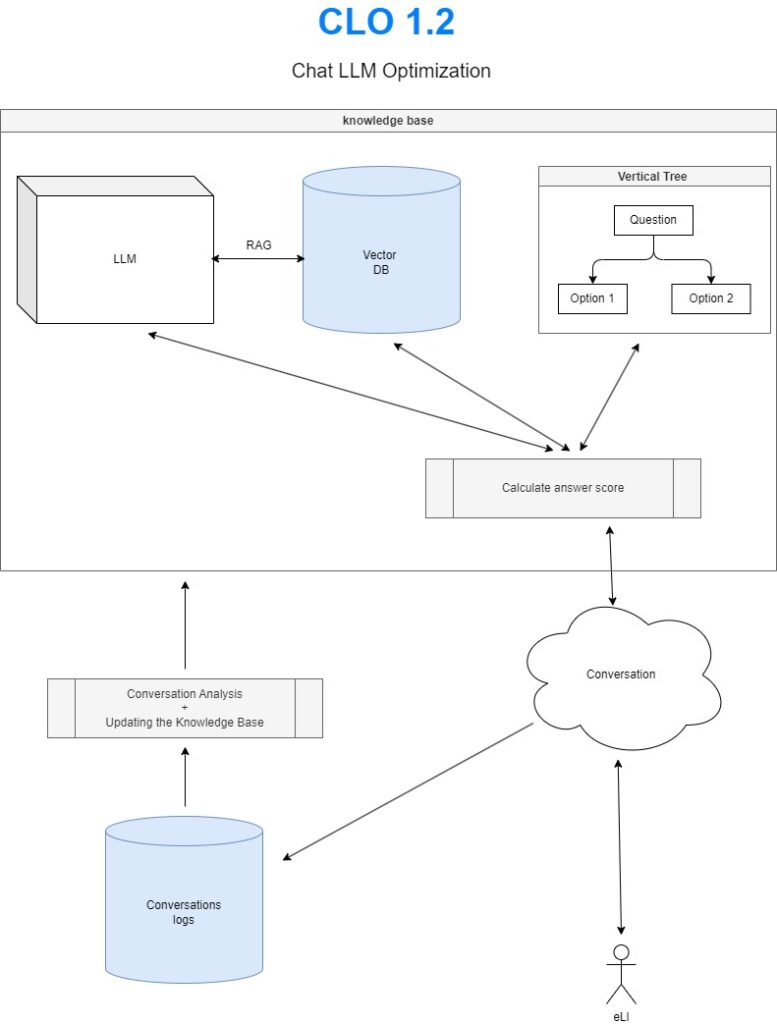

ארכיטקטורת CLO מציעה מענה אפשרי לאתגרים

הרעיון הוא להשתמש בשלושה מקורות / מנועי ידע מסוגים שנים, לצורך מתן תשובה אופטימלית ללקוח

והוספת שכבה שמנהלת את הפנייה לכל אחד מהמשאבים ומחשבת את ציון האיכות של התשובה.

הרכיב הראשון הוא הפשוט ביותר ועובד כעץ החלטה המבוסס על שאלות ובחירת תשובות אפשרויות, מרשימה סגורה.

הרכיב השני הוא VECTOR DB – רכיב זה משמש אותנו בשני אופנים שונים: מציאת מידע רק לפי מרחק וקטורים במאגר ועבודה משולבת עם מודל ה RAG – LLM

הרכיב השלישי הוא מודל LLM שיכול לעבוד באופן עצמאי או יחד עם נתונים מה VECTOR DB

בהמשך נדבר על איך עובדים עם הרכיבים האלה יחד ואיך אפשר לחשב ציון לתשובות שלנו 🙂